CodeGeeX本地模式使用指南:高效编码体验

CodeGeeX 本地模式使用指南

CodeGeeX 本地模式可以将本地 API 服务接入智能问答和代码补全中,以实现安全、隐私、高效的编码体验。您可以将任何与 OpenAI 兼容的 RESTful API 接入到 CodeGeeX 的插件中。

本地模式使用帮助

1、打开侧边栏,从菜单中进入 「本地模式」

2、打开「模型」页面,填写 API 信息

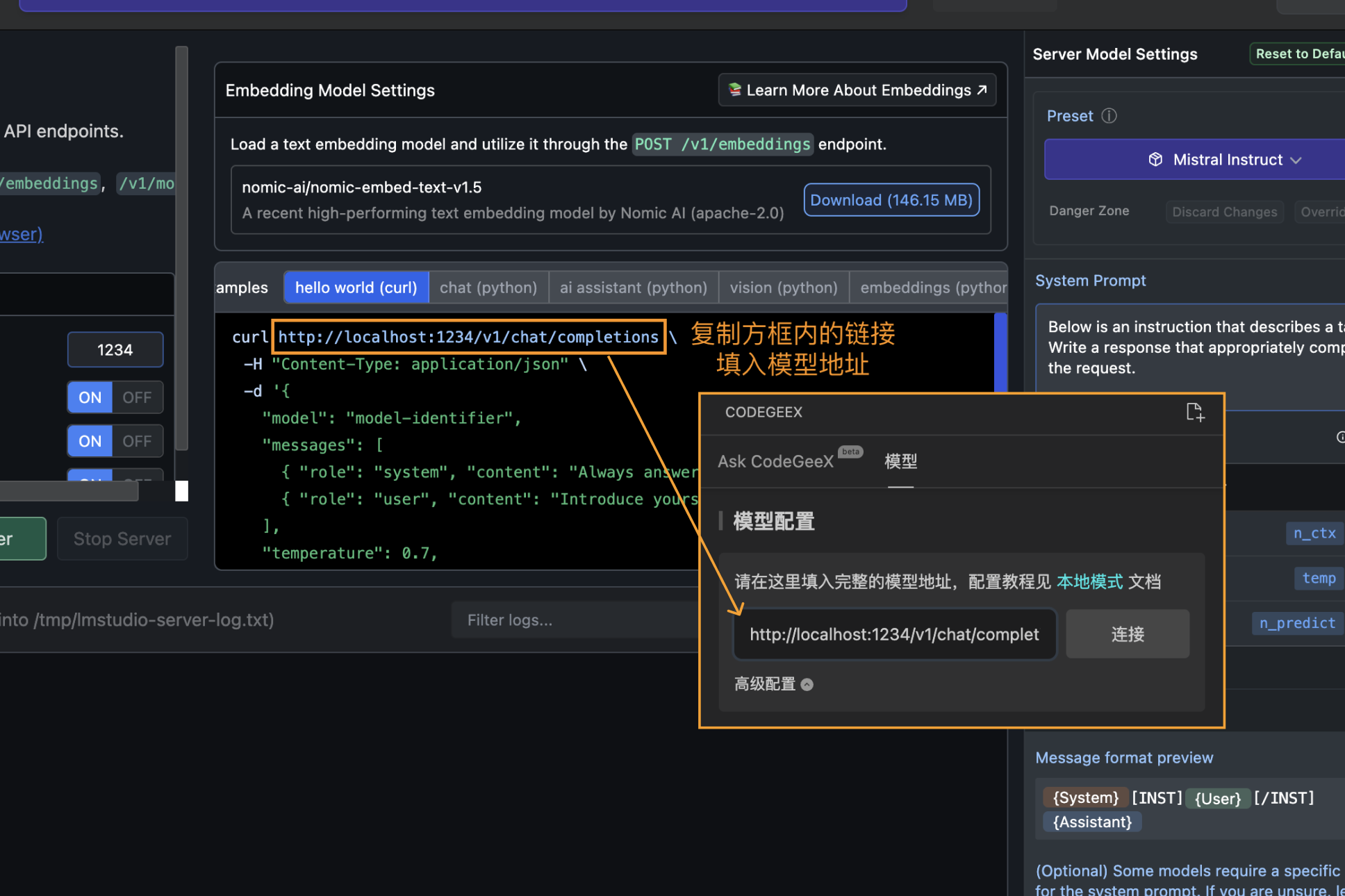

模型地址:可以使用任何与 OpenAI RESTful API 兼容的地址,例如 http://localhost:1234/v1/chat/completions

API KEY:如果您的 API 服务需要鉴权,请在此填入密钥。插件会在请求 API 的 HTTP HEADER 中添加以下信息

Authorization: Bearer <token>模型名称:如果您的 API 支持多个模型,可以在此填入模型名称。插件会在请求 API 的 PAYLOAD 中添加以下信息

{

"model": "<MODEL NAME>"

}

3、验证配置

可以使用「连接」验证配置是否正确,当显示为「已连接」时,您可以开始体验 CodeGeeX 的本地模式。

4、设置高级参数

如果您对 模型的 temperature 或 top_p 等参数有特别需求,可以展开 聊天 和 代码补全 中的「高级配置」进行配置,插件会用以下协议与 API 通信

{

"model": "<MODEL NAME>",

"messages": [

{

"role": "user",

"content": "CodeGeeX is awesome!"

}

],

"temperature": "<TEMPERATURE>",

"top_p": "<TOP_P>",

"max_tokens": "<MAX_TOKENS>",

"presence_penalty": "<PENALTY>",

"stream": true,

"stop": []

}常用模型推理工具

1、使用 FastChat 提供 API 服务

FastChat 是一个高效的对话系统框架,您可以使用该框架快速部署CodeGeeX4模型。官方文档: https://github.com/lm-sys/FastChat

如需技术协助请通过 CodeGeeX 公众号加入用户群。

2、使用 Ollama 在个人电脑中启动推理服务

Ollama 是一个开源的本地部署大型语言模型的工具,您可以点击链接下载 Ollama:https://ollama.com/download

官方文档见:https://github.com/ollama/ollama

通过Ollama使用插件需要配置跨域,您可以按照以下配置接入:

ollama 版本 > 0.2.0

- 您可以通过在终端输入

ollama -v检查您安装的ollama版本

- 您可以通过在终端输入

配置跨域所需的环境变量

- 在终端输入

export OLLAMA_ORIGINS="*"或launchctl setenv OLLAMA_ORIGINS "*"来设置环境变量,Windows环境可以在环境变量中手动配置 - 设置后需要重启 ollama 服务和 IDE(VSCode 或其他环境) 使环境变量生效

- 不同环境配置的方式不同,请参考https://github.com/ollama/ollama/blob/main/docs/faq.md#how-do-i-configure-ollama-server

- 在终端输入

启动CodeGeeX4

- 在终端输入

ollama serve - 打开一个新的终端,在终端输入

ollama run codegeex4

- 在终端输入

配置接口地址

- 在插件的模型配置页填写模型地址:

http://localhost:11434/v1/chat/completions - 打开模型配置的高级模式,在模型名称栏填写:

codegeex4

- 在插件的模型配置页填写模型地址:

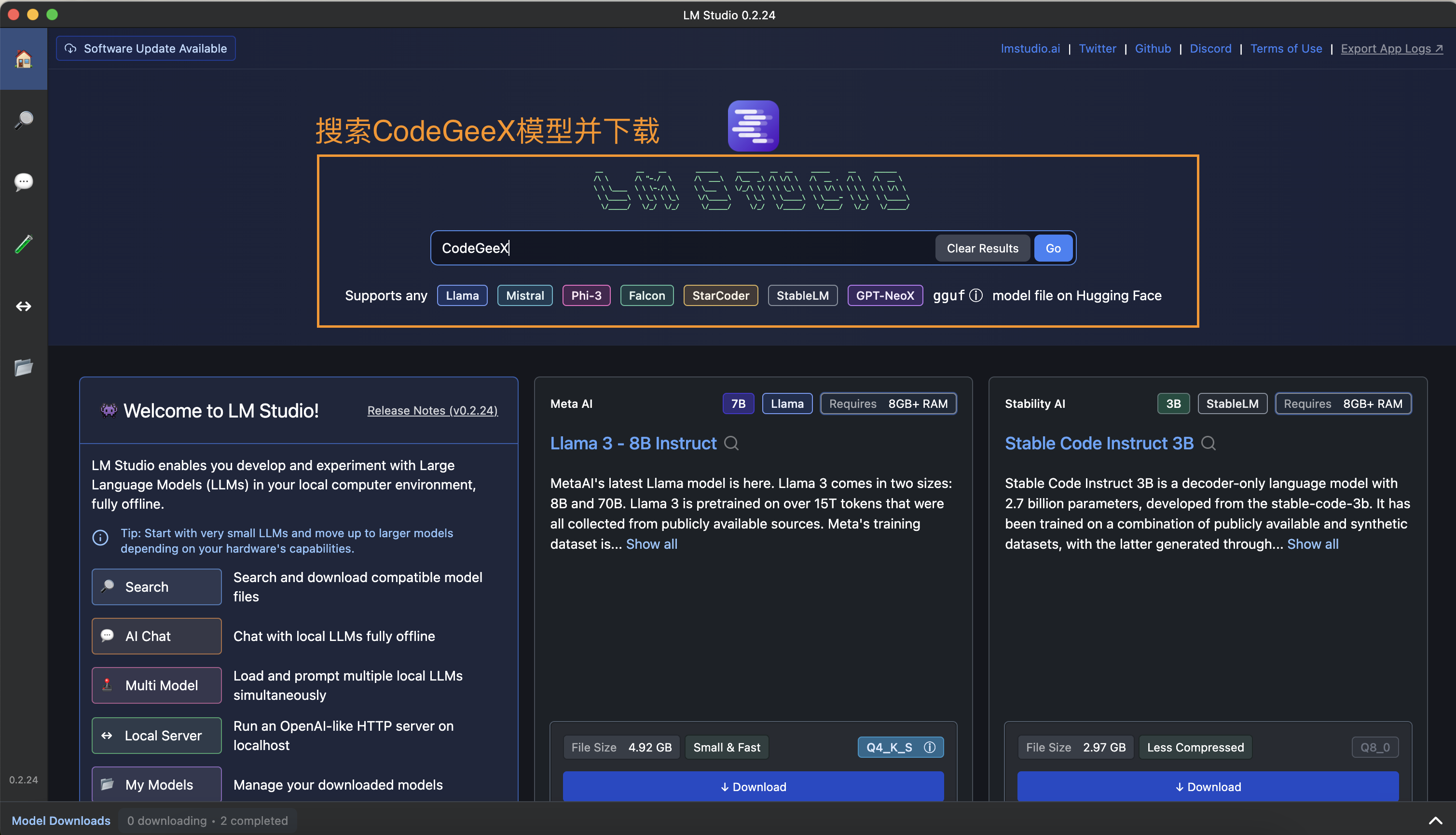

3、使用 LM-Studio 在个人电脑中启动推理服务

LM Studio 是一个用于部署本地和开源大型语言模型的工具,您可以点击链接下载 LM Studio:https://lmstudio.ai/

官方文档:https://lmstudio.ai/docs/welcome

| 下载后打开LM Studio,搜索CodeGeeX4模型并下载 |

|

|---|---|

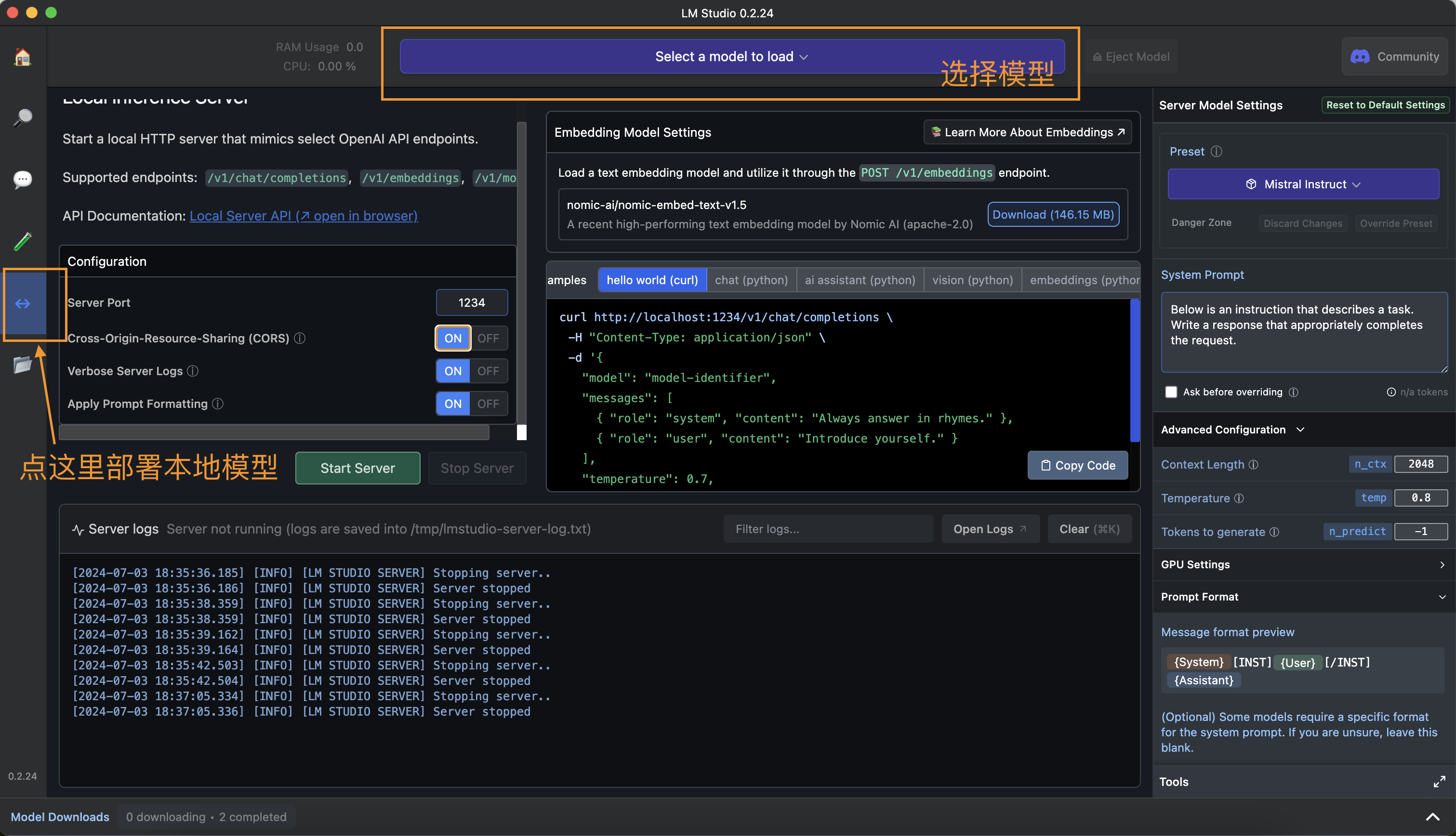

| 你可以点击侧边栏找到模型部署页,在这里部署本地模型 |

|

| 注意:在选择模型前请打开跨域(默认是关闭的,这会导致插件无法连接到本地模型) |

|

| 选择并启动服务器,模型就部署成功了。 这时候只需要复制部署链接到模型配置页,就可以使用插件的本地模式啦! [[EMOJI:%F0%9F%8E%89]] |

|

4、使用 Fastapi 部署本地模型

参考该教程 https://github.com/THUDM/CodeGeeX4/tree/main/local_mode (中文地址)

-

安装依赖项 (python>=3.9)

-

启动服务即可开始使用

常见问题

1、API 无法连接

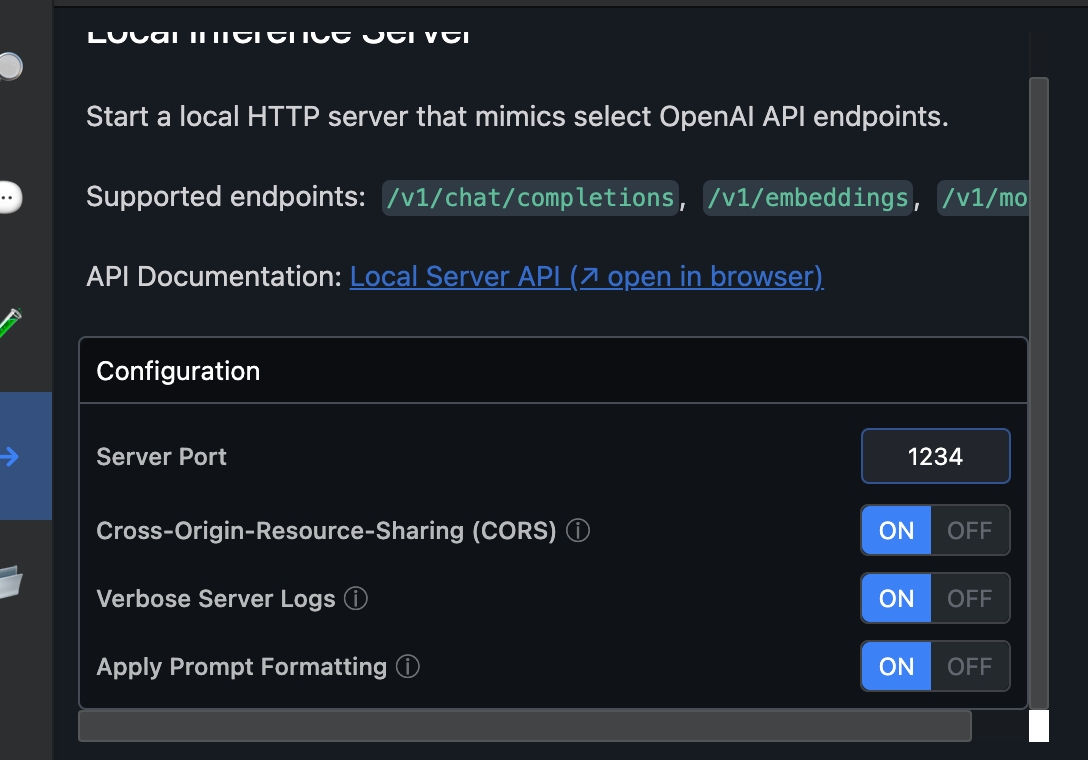

如果您使用 LM STUDIO 提供 API 服务,请打开跨域支持。如下图,开启

Cross-Origin-Resource-Sharing